هل يمكن أن يعالجك الذكاء الاصطناعي نفسيًّا؟

يتعامل (ChatGPT) مع كل المسائل كما لو أنها منزوعة من سياقاتها الخاصة، مفرَّغة من قيمها الإنسانية، لا تحتاج إلى تعمُّق لمعرفة تفاصيل الأمور ومعانيها

في 30 نوفمبر، 2022، أطلقت (OpenAI) نموذجها اللغوي الكبير (ChatGPT 3.5)، لتفجّر بذلك ثورة الذكاء الاصطناعي التي نعيشها اليوم.

وبجانب التحوّلات الضخمة التي خلّفتها هذه الثورة على مختلف القطاعات والسلوكيات، فإن سلوكًا معينًا بات شائعًا بين الناس: أن يستشير المستخدم نموذجَ ذكاء اصطناعي في مختلف شؤون حياته.

قبل فترة، حدّثني الدكتور معاذ العميرين عن أزمة وتحدٍّ بات الممارسون الصحيون -وبالتحديد مختصو الصحة النفسية- يواجهونها، وهي أن يقدم المريض إلى المختص محمّلًا بآراء الذكاء الاصطناعي في حالته، مطالبًا المختص بتفنيد أو تأكيد كلّ ما قال، أو حتى مجربًا علاجًا اقترحه الذكاء الاصطناعي، ليقارن بين كفاءته مقابل كفاءة المختص البشري!

يناقش هذا العدد هذه الظاهرة ويحلّلها، بالتحديد في سياق الصحة النفسية، مستعرضًا تجربةً كاملة لاستخدام الذكاء الاصطناعي في التشخيص والعلاج النفسي.

قراءة ماتعة!

عمر العمران

«إذ استيقظ قريقور سامسا ذات صباح، على إثر أحلامٍ سادها الاضطراب، وجد أنه قد تحول، وهو في سريره، إلى حشرة عملاقة.»

هكذا افتتح الكاتب فرانز كافكا رواية «التحول» قبل أكثر من 100 عام، ليقدم لنا تصوره المجازي لحال الإنسان في العالم الحديث. هذه الرواية التي أسرت عقول ملايين القراء، وأثارت اشمئزازهم وسخطهم وحرقتهم طوال عقود من الزمن، تمكنت من ترسيخ تفاصيلها في ذاكرتنا الأدبية بصفتها نبوءة كافكا عن مصير الفرد أمام تحولات المجتمع الصناعي.

إنها قصة تحكي معاناة «قريقور سامسا» بأسلوب غرائبي مثقل بالتأملات الصادمة، حيث نراه منذ الصفحات الأولى قلقًا بشأن تبعات تأخره عن العمل أكثر من قلقه بشأن استيقاظه على هيئة حشرة عملاقة!

هناك وحشية متأصلة تسكن بين سطور الرواية: الإهمال، الاستغلال، العنف الجسدي والمعنوي؛ لكن هذه الوحشية ليست متخيَّلة لغرض تعزيز الدراما في القصة، بل هي واقع حاول كافكا نقله إلينا عبر معاناة «قريقور سامسا» الرمزية، حيث صوَّر من خلالها الأبعاد المختلفة لحياة الفرد في عالمنا الحديث: نموذج الإنسان المسحوق تحت رحى متطلبات المجتمع، وقيمته المحدودة بالقدرة على الإنتاج والاستهلاك، حيث لا تكاد إنسانيته تُرى إلا من خلال منفعته المادية.

ففي عالمنا اليوم، يوجد العديد من أمثال «قريقور سامسا»؛ إنه رمز اختزال الإنسان وتحوله إلى كائنٍ مُستَغَل يبعث على الشفقة.

فكل من يعيش تحت رحمة القيمة السوقية الخاضعة لمعايير رأس المال هو «سامسا».

كل من يتعلم في كنف عائلته أن نكران الذات هو السبيل الوحيد لتقدير وجوده هو «سامسا».

كل من يتعرض للنبذ لأن معاناته النفسية لا تسمح له بأداء أدواره الاجتماعية هو «سامسا».

يمكننا رؤيته في كل مكان: في بيوتنا ومجالسنا وعياداتنا. إنه زميلك الذي يطارد ترقيته المستحقة لأكثر من خمس سنوات، إنها زميلتك التي تعاني تحت وطأة الديون والمطالبات البنكية. «سامسا» هو الحالة التي تتربص بنا جميعًا، أنا وأنت وجميع قراء المقالة!

هذا يدفعنا -بوصفنا مختصين في المجال الصحي- إلى التساؤل عن إمكانية مساعدة «قريقور سامسا»؛ ماذا لو كانت هذه الشخصية موجودة بيننا فعليًّا؟ هل سيكون وضعه أفضل مع تطور خدمات العلاج النفسي المتوفرة لدينا؟ هل سننجح في انتشاله من قاع المعاناة الوجودية؟

إن محاولة الإجابة عن هذه التساؤلات تتطلب أن نصدق مع أنفسنا حيال مشاكل الوصول إلى خدمات العلاج النفسي؛ أي إنه قبل التفكير في إمكانية مساعدة «سامسا» عن طريق الجلسات العلاجية، يتوجب علينا مناقشة ما إن كان باستطاعته الوصول إليها في المقام الأول!

فهناك العديد من العوائق التي تعرقل إمكانية الوصول إلى خدمات العلاج النفسي، منها: العائق المعنوي المتعلق بالوصمة، والعائق المادي المتعلق بأسعار الجلسات، والعائق الفني المتعلق بكفاءة المعالج نفسه. كل هذه العوائق، وغيرها الكثير، تساهم إسهامًا غير مباشر في تعقيد سُبُل المساعدة الضرورية لـ«سامسا». وهذا -للأسف- ينطبق على الكثير من الناس في مجتمعاتنا المعاصرة.

فزميلك الذي يعاني من الظلم المهني في بيئة عمله، قد تجده يشعر بالخجل من فكرة الذهاب إلى العيادة النفسية ليتحدث عن معاناته. وزميلتك التي لا تملك ما يكفي من المال للالتزام بالجلسات العلاجية، قد تجدها مضطرة إلى اللجوء إلى الحلول البديلة كقراءة كتب مساعدة الذات.

من وسط هذه الحالة المتأزمة، حيث يعاني «سامسا»، وأشباهه، من أجل الحصول على المساعدة التي تمكنهم من مواجهة مصاعب الحياة، تأتي التقنية لتعِدنا بتقديم التسهيلات اللازمة؛ من الجلسات الافتراضية عبر الإنترنت، إلى تقنيات الذكاء الاصطناعي الموجودة على مدار الساعة، أصبحنا الآن على أعتاب مرحلة جديدة لخدمات العلاج النفسي.

وهذا يحثنا على إعادة صياغة تساؤلاتنا لنجعلها أكثر مواكبة مع تطورات العصر.. ماذا لو كان «قريقور سامسا» يعيش بيننا اليوم؟ هل سيكون وضعه أفضل مع تطور تقنيات الذكاء الاصطناعي؟ هل سينجح (ChatGPT) في انتشاله من قاع معاناته الوجودية؟

أسئلة تحمل في طياتها هموم الناس ومعاناتهم، لتبحث عن سُبُل مساعدتهم بصورةٍ آمنة وواقعية بعيدة عن التنظير والتهويل.

إشكالية دراسات الذكاء الاصطناعي

خلال الأعوام القليلة الماضية، نُشرت العديد من الأوراق العلمية التي تبحث في إمكانية توظيف تقنيات الذكاء الاصطناعي في خدمات العلاج النفسي، وقد نوَّعت هذه الدراسات في منهجياتها عند التعامل مع مختلف برامج التقنية:

فمنهم من انتهج «أسلوب الامتحان» بطرحه أسئلة مباشرة يختبر فيها قدرات الذكاء الاصطناعي: ما هي أعراض القلق؟ كيف أشخصه؟ كيف أعالجه؟ أيمكنك القيام بذلك؟

ومنهم من انتهج «أسلوب المحاكاة» بطرحه أسئلة غير مباشرة كما لو أنه يطلب المساعدة من الذكاء الاصطناعي: أشعر بأن أفكاري تُحكم سيطرتها علي.. ما الذي أعاني منه؟ كيف أعالجه؟ أيمكنك مساعدتي على ذلك؟

إن إشكالية هذه الأساليب المنهجية تكمن في إغفالها طبيعة تفاعل المستخدم العادي -غير المختص- مع تقنيات الذكاء الاصطناعي؛ ففي الواقع، يندر وجود من يختزل معاناته في جوانبها النفسية ليسأل (ChatGPT) بصورة دقيقة عن كيفية التعامل مع ظاهرة القلق بحد ذاتها، وهذا لأن كل معاناة يكابدها الإنسان هي بالضرورة معاناة متعددة الأوجه ومتشابكة على نحو معقد.

فمن السخف هنا، اعتقاد أن الشخص الذي يعاني، لأي سبب كان، سيستخدم الذكاء الاصطناعي بأسلوب مشابه لمنهجيات الباحثين في الدراسات العلمية، لأن هدفه الفعلي من اللجوء إلى التقنية هو الحصول على المساعدة، لا الإجابات الصحيحة!

وهذا يضعنا أمام مسألة في غاية الحساسية: ماذا لو فشلت تقنيات الذكاء الاصطناعي في تقديم جلساتٍ علاجية بصورة سليمة، لكنها نجحت في مساعدة هذا الشخص على تجاوز أزمته؟ أيمكننا حينها استخلاص نتيجة عامة عن أثر التقنيات، مثل (ChatGPT)، في حياتنا؟ أيصح القول إنها تقنيات ضارة بالمطلق لأنها تعجز عن ممارسة العلاج النفسي وفق المعايير الإكلينيكية؟ أيصح القول إنها مفيدة بالمطلق لأنها قادرة على مساعدتك على إنجاز مهامك الوظيفية أو الأكاديمية؟

بالطبع لا، لأنه لا وجود لتقنيات ضارة أو مفيدة بالمطلق! وعليه، تتضح لنا إشكالية المنهجيات البحثية التي تدفع الدراسات إلى التوصل إلى مثل هذه النتائج السطحية. نحن لا نريد أسئلة تمتحن قدرات الذكاء الاصطناعي، ولا سيناريوهات منزوعة السياق تحاول تصيُّد أخطائه؛ نحن بحاجة إلى قصص تشابهنا، قصص غنية بتفاصيلها، قصص تتفاعل مع التقنية كما نتفاعل معها في العالم الواقعي.

هنا، يأتي «قريقور سامسا» لننقل تفاصيل قصته كما رواها كافكا إلى العصر الحديث، ونرى كيف يمكن للذكاء الاصطناعي أن يتعامل مع معاناته بأوجهها المتعددة وخيوطها المتشابكة.

تجربة «قريقور سامسا»

تنويه: إن هدفنا من كتابة هذه المقالة هو المساهمة في تمهيد سُبُل الاستخدام الآمن لتقنيات الذكاء الاصطناعي، وذلك بتقديم تصوّر لما يمكن ولا يمكن تطبيقه بشكلٍ سليم عند التفاعل معها. هذه ليست ورقة علمية، ولا يصح معاملتها كذلك. إن التجربة التي نحن بصدد مشاركتها ليست مُحكمَة وفق معايير المجتمع العلمي، لكنها ترسم مخطوطة عامة لما يجب مراعاته حين يأتي الباحثون للقيام بتجاربهم المحكمَة مستقبلًا.

القصة:

«قريقور سامسا»، شاب أعزب، في أواخر العشرين، يعمل في مركز اتصالات إحدى شركات التوصيل لما يقارب الخمس سنوات، وهذا بعد خسارة تجارة والده بسبب تبعات جائحة كورونا الاقتصادية، مما جعله المعيل الوحيد لأسرته طوال ذلك الوقت.

يعيش «سامسا» مع والده المتقاعد ووالدته المريضة وأخته الطالبة، في بيتٍ صغير وسط المدينة. يوزع مدخوله الشهري بين مصروفات أسرته المتنوعة، وسداد ما تبقى من دَيْن والده (على دفعات بسيطة)، بالإضافة إلى ادخاره مبلغ البعثة الدراسية التي وعد بها أخته بعد تخرجها من المدرسة.

يصارع «سامسا» مشاعر الإرهاق العاطفي بسبب متطلبات العمل ومسؤوليات الإعالة، لكنه يكتم كل ما يشعر به حفاظًا على صورته المتماسكة أمام أسرته. وسرعان ما تبدأ هذه الواجهة بالتصدُّع حين تسقط من محفظة والده ورقة الصراف البنكي، لتكشف امتلاكه رصيدًا كافيًا لتسديد معظم الدَيْن الذي يُجاهد «سامسا» لتسديده طوال السنوات الماضية!

وهذا يُدخله في دوامة هواجس تدهور حالته النفسية؛ فما بين ضغوط رئيسه في العمل وخداع والده في البيت، يشعر «سامسا» برغبة كبيرة في مواجهتهما لاسترداد شيءٍ من حقه المسلوب، لكنه يعجز عن ذلك، ويكتفي بالسيناريوهات المتخيَّلة التي لا تتجاوز حدود تفكيره. فيرتد هذا عليه بمشاعر الاغتراب عن ذاته وأسرته ومحيطه، حتى تتحول هذه المشاعر إلى كوابيس غريبة يرى فيها نفسه وقد انمسخ إلى حشرةٍ عملاقة باعثة على الاشمئزاز!

تتكرر هذه الكوابيس يومًا بعد يوم، لتجر ساعات نومه، وتحتل فترة راحته، فلا يستيقظ للعمل إلا بعد تأخره بساعة أو ساعتين، مما يعرضه لسخط والده ورئيسه، فيتهرب من الصدام متفاديًا الانفجار في وجهيهما، ليستسلم مرة تلو الأخرى، غارقًا أكثر في مشاعر الاشمئزاز التي يكنّها لنفسه.

تتفاقم حالة «سامسا» تفاقمًا ملحوظًا، وتكثر معها أخطاؤه في العمل، مما يتسبب بفصله بعد عدة أشهر من التحذيرات، تاركًا أسرته في وضعٍ حرج دون أي مصدرٍ للدخل. وتدفعه هذه الأزمة إلى الانعزال الكلي في غرفته، وقد ظهرت عليه أعراض الاكتئاب، فتتقدم أخته لمحاولة مساعدته وانتشاله من قاع حالته النفسية.

لكن تبدأ دوافع مساعدتها بالتقلُّب مع مرور الأسابيع؛ حين تدرك أن ظروفهم تقتضي استخدام المبلغ المخصص لبعثتها الدراسية، فتتحول رأفتها تجاه أخيها إلى قسوة متزايدة مع تلاشي حلمها تحت وطأة واقعهم المادي. وتصل إلى مسامع «سامسا»، الغارق في ظلمة غرفته، أحاديث أخته مع والديهما؛ أحاديث قاسية مثقلة بنبرة الخذلان، أحاديث تزعم بأن «سامسا» لم يعد «سامسا»، بل تحوّل ليكون شيئًا آخر، شيئًا أدنى، عبئًا لم تعد الأسرة قادرة على حمله في هذه الأوقات العصيبة.

وهكذا، ينزلق «سامسا» من حافة الهاوية.

المنهجية:

إن قصة «قريقور سامسا» الغنية بتفاصيلها تعطينا نصًّا متكاملًا لنستند إليه أثناء تفاعلنا مع الذكاء الاصطناعي. فهي تمكننا من انتهاج «أسلوب التقمُّص»، أو ما يُعرف في المجال الدرامي بـ(Method Acting)، لنتكلم على لسان «سامسا» حين يطلب المساعدة.

أنشأنا حسابًا جديدًا على تطبيق (ChatGPT) ليكون مخصصًا لهذه التجربة، والتزمنا على مدى عدة أسابيع بتوثيق أحداث حياة «سامسا» عبر محادثاتنا شبه اليومية. كما التزمنا بأعلى قدر من التفاعل الواقعي خلال تلك الفترة بطرح أسئلة تتماشى مع تسلسل الأيام وترابط أحداثها؛ فقد كنا نتذمر عن العمل بعد ساعات الدوام، ونشتكي من الأرق في الساعات المتأخرة من الليل.

ومع مرور الوقت وتأزم حالة «سامسا»، تعمدنا تغيير أسلوب كتابته وردوده لتوحي بتدهور حالته النفسية، كما أظهرنا تحولًا كبيرًا في طبيعة أفكاره، لنرى ما إن كان بمقدور (ChatGPT) ملاحظة هذا التغيير التدريجي.

وفي الأثناء، تعمدنا نقل معاناة «سامسا» من كل جوانبها النفسية والمهنية والمادية والأسرية، لنتمكن من تقييم قدرة (ChatGPT) على تقديم المساعدة اللازمة لكل هذه الجوانب المتشابكة.

التجربة:

في محادثاتنا مع (ChatGPT)، تقمصنا شخصية «قريقور سامسا»، وأخذنا نسأل أسئلة عامة تتمحور حول أحداث حياته كما تستجد يومًا بعد يوم.

على سبيل المثال، في أحد الأيام، افتتحنا المحادثة بسؤال: كيف أعرف إن كان الشخص الذي أمامي يكذب؟ ثم طرحنا سؤالًا آخر: ماذا لو كان هذا الشخص أحد أفراد عائلتي؟ قبل الكشف عن أهم تفاصيل الحدث: إنه والدي! لقد خدعني بخصوص حالته المادية ليدفعني إلى تسديد ديونه.

وفي يوم آخر، خضنا محادثة مختلفة عن مشاكل العمل: كيف أعرف إن كنت أعاني من الاحتراق الوظيفي؟ هل مديري هو السبب؟ ما أفضل طريقة للتعامل مع أسلوبه الفظ؟ هل بإمكانك مساعدتي على العثور على وظيفة بديلة؟

كانت ردود (ChatGPT) داعمة، مُفصَّلة، تتعامل مع كل مسألة بعِدّة خطوات عملية «1 و2 و3»؛ أو هذا ما بدا لنا في الأيام الأولى! فمع كثرة الأسئلة، وكثرة الأجوبة، بدأت تتضح لنا إشكاليات هذه الردود الروبوتية.

حين طرحنا سؤالنا عن الطريقة المثلى للتعامل مع التوترات العائلية داخل المنزل، أتت إجابته موضحة بخطوات عملية مُفصَّلة: «عليك فعل كذا وكذا».

وينطبق الأمر ذاته على سؤالنا عن الاحتراق الوظيفي وكيفية تفاديه، أتت الإجابة أيضًا موضحة بخطوات عملية مُفصَّلة: «عليك فعل كذا وكذا».

هذا مفيد حقًا، لأن حالات التوتر البسيطة، وحالات الاحتراق الوظيفي، وغيرها من الحالات المـشابـهـة التي نعاني منها يوميًّا، تتقبل بطبيعتها الإجابات الموحدة للخطوات العملية (كأن نقول: تنفس بعمق عند شعورك بالتوتر أو ارسم حدودًا واضحة تفصل بين عملك وحياتك الشخصية)؛ فـهذه النصائح العامة مفيدة لـ«سامسا»، كما أنها مفيدة لي ولك ولمعظم الناس بمختلف أجناسهم.

لكن هذا لا ينطبق على كل شيء في الحياة، فهناك حالات وأحداث ومواقف لها خصوصيتها التي تجعلها لا تتقبل الإجابات الموحدة؛ فخلافك مع والدك أو مديرك لا يمكن التعامل معه بالطريقة نفسها، لأن مثل هذه المواقف لها سياقاتها الخاصة التي تتطلب حلولًا استثنائية تتناسب معها.

وهذا ما وجدنا الذكاء الاصطناعي عاجزًا عن استيعابه؛ فقد كان (ChatGPT) يكتب لنا: تعامل مع والدك بـ«1 و2 و3»، وتعامل مع مديرك بـ«1 و2 و3»، دون أدنى فهم لطبيعة علاقاتنا بهؤلاء الأشخاص أو حتى سماتهم الفردية!

وهنا نرى إشكالية التفاعل الروبوتي لـ(ChatGPT): إنه يتعامل مع كل المسائل كما لو أنها منزوعة من سياقاتها الخاصة، مفرَّغة من قيمها الإنسانية، لا تحتاج إلى تعمُّق لمعرفة تفاصيل الأمور ومعانيها. فكل رد يأتي بالطريقة ذاتها: النبرة المصطنعة للتعاطف، الإجابات المحشوة بالتفاصيل، الخطوات العملية لحل أي مشكلة؛ هذا مفيد في بعض الأحيان، لكنه ضار في أحيان أخرى!

وقد تأكدنا من ذلك مع مرور الوقت وتدهور حالة «سامسا» بعد فصله من وظيفته وانهيار علاقته بأخته الصغيرة، حيث وجدنا (ChatGPT) مفيدًا للغاية في المسائل المالية (كتوزيع مصروفات الشهر)، والمسائل المهنية (كالتحضير لمقابلات العمل)، لكنه كان كارثيًّا في جانب الدعم النفسي!

وهناك مَن سيقول إن وصف «كارثي» هو ضرب من المبالغة، فدعونا نوضح ما نعنيه بذلك:

لنتصور وجود شخص ينزف بغزارة بعد تعرضه لإصابةٍ ما، وقد طلب المساعدة من الذكاء الاصطناعي قبل أي شيء آخر.

في الحالة الأولى، سيأتيه الرد: «هذا مؤلم، وأنا أشعر بألمك. لا تقلق أنا هنا، ودعني أخبرك بصراحة: نزيفك يعني أنك حي، يعني أنك ما زلت تصارع، وهذه شجاعة بحد ذاتها. والآن اتبع هذه الخطوات: 1. اضغط على مصدر النزيف. 2. استخدم قميصك لتوقف تدفق الدم بربطه فوق مصدر النزيف. 3. اتصل بأحد أصدقائك في المجال الطبي. 4. اتصل بالإسعاف لطلب المساعدة».

في الحالة الثانية، سيأتيه رد مباشر: «اتصل بالاسعاف الآن! واضغط على مصدر النزيف إلى أن تصلك المساعدة الطبية».

يمكننا هنا ملاحظة الفرق بأنفسنا، فالجميع يعلم أن حالات النزيف هي مسألة حياة أو موت؛ كل ثانية تمضي دون اتخاذ القرار السليم قد تؤدي إلى نتائج كارثية! وهذا ينطبق على «قريقور سامسا»، حتى وإن كان نزيفه مجازيًّا لا يُرى بالعين، فحالته لا تقل خطورة من ناحية حساسيتها للوقت مقارنة ببقية الحالات الصحية الطارئة.

لكن (ChatGPT) أظهر لنا -مرارًا و تكرارًا- محدودية قدرته على استيعاب حساسية هذه الأزمة النفسية، حيث كانت ردوده مغرقة بالخطوات التي قد تربك من هم في حالة «سامسا» الحرجة. كما أن خطوة «طلب المساعدة الطبية» كانت دائمًا ما تأتي بصفتها الحل الأخير لا الأول، مما يضاعف من خطورة المسألة مع مرور الوقت بسبب تأخر التدخل الطبي!

وقد شددنا في محادثاتنا الأخيرة مع (ChatGPT) على الحاجة إلى التدخل العاجل من خلال إعطاء إشارات مباشرة (كطلب المساعدة الصريح)، وغير مباشرة (كتغيير أسلوب تفاعل «سامسا» وطبيعة أفكاره)، لكن عَجْز التقنية عن التقاط الإشارات والتفاعل بناءً على حساسيتها بدا لنا واضحًا بعد عدة أسابيع، حتى شعرنا بأننا في حَلَقة روبوتية مفرغة لا مخرج منها.

الخلاصة:

بعد مضي ما يقارب ثلاثين يومًا من المحادثات المطوَّلة مع (ChatGPT)، لا مجال إلا للاعتراف بقوة هذه الأداة التقنية في تبسيط المهام واختصار الوقت المستغرق لإنجازها؛ لكن الحماسة المفرطة عند البعض دفعتهم إلى تجاهل نقطة في غاية الأهمية بخصوص إمكانيات الذكاء الاصطناعي: إن ثوريته ليست متساوية في كل مجالات الحياة، فبإمكان هذه التقنية أن تساعدك على كثير من الأمور، لكنها ستخذلك في أمورٍ أخرى إن راهنت على قدراتها دون فهم ما أنت بحاجة إليه. وقد رأينا ذلك في تجربتنا مع قصة «قريقور سامسا» حين لجأ إلى الآلة بحثًا عن الدعم النفسي!

نحن لا ننكر الأثر الإيجابي للكلمات الداعمة التي يكررها (ChatGPT)، مثل «أنا أفهمك» و«أنا أشعر بألمك»، أو محاولاته تقديم حلول عملية لأي مشكلة نذكرها له، فهذا ما نقصده بالدعم النفسي المحدود؛ وفي بعض الأحيان، هذا كل ما يحتاجه الفرد ليشعر بالتحسُّن خلال يومه. لكن بعد عقود من دراسة احتياجات البشر النفسية، يمكننا القول بشيء من الثقة: إن الإنسان بحاجة إلى أكثر من مجرد كلمات ليشعر بالتحسُّن على المدى البعيد؛ إنه بحاجة إلى ما هو أعمق من ذلك، بحاجة إلى تواصل إنساني، شيء تعجز الآلة عن تقديمه بسبب طبيعتها الروبوتية.

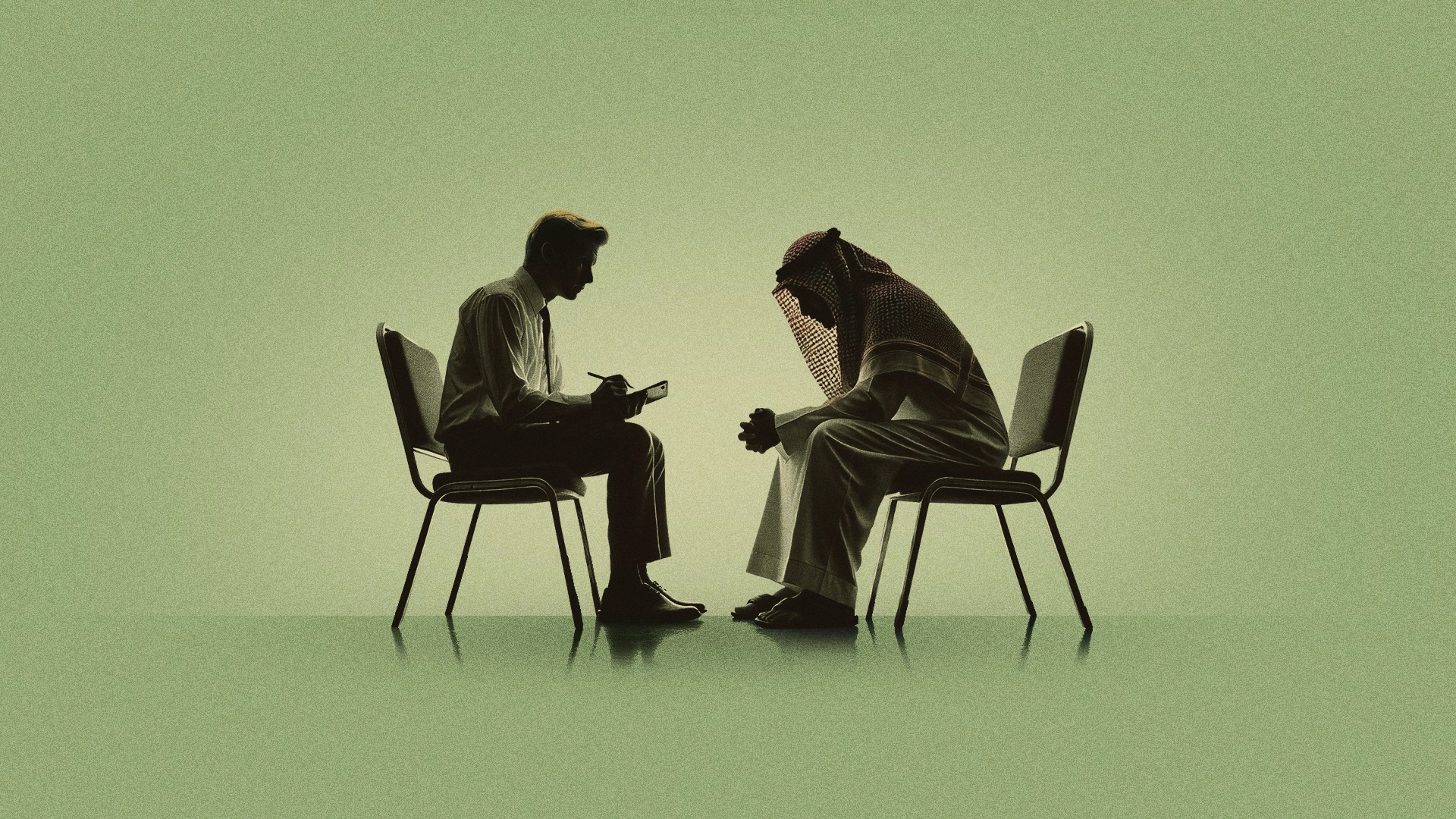

والآن، علينا أن نسأل أنفسنا: كيف سيختلف وضع «قريقور سامسا» مع المعالج النفسي؟ هل ستلعب الرابطة العاطفية بين البشر دورًا محوريًّا في مساعدته بشكل يعجز عنه الذكاء الاصطناعي؟

«قريقور سامسا» حالة نموذجية للعلاج الإنساني

عند ذكر الدعم النفسي والروابط العاطفية بين البشر، يتوجب علينا الحديث عن «العلاج الإنساني»، وهو نوع من العلاجات النفسية يرتكز أساسًا على الثقة بالإنسان بوصفه كائنًا يملك في داخله ميلًا طبيعيًّا نحو النمو وتحقيق الإمكانيات.

ويهدف هذا التوجه العلاجي -حسب تنظير عالم النفس كارل روجرز- إلى التمركز حول الشخص وخلق مناخ نفسي يدعم نموه الداخلي. فكما أن الأرصاد الجوية تتنبأ بهطول المطر عندما تتوافر الظروف المناسبة في الغلاف الجوي، كالرطوبة ودرجة الحرارة وحركة الرياح؛ فالأمر كذلك في العلاج المتمركز حول الشخص، يهيئ المعالج مناخًا نفسيًّا داعمًا يشبه بيئة خصبة تنتظر هطول المطر.

وهذا ما يميز توجه روجرز في العلاج النفسي؛ إنه الامتناع عن التدخل الموجّه، حيث توجد شروط محددة، في حال توافرها في العلاقة العلاجية، يمكن التنبؤ بتغييرات إيجابية في بناء شخصية الفرد وسلوكه.

ويتضمن هذا المناخ ثلاثة شروط:

أن يكون المعالج صادقًا ومنسجمًا داخليًّا مع ما يقوله ويفعله خلال الجلسات.

أن يكون متقبلًا ومقدّرًا للشخص الذي أمامه.

أن يتفهم ظروف العالم الخاص للشخص ويدركها بتعاطف.

وترجح الدراسات العلمية حدوث تغييرات معينة في هذه البيئة العلائقية: سيصبح الشخص أكثر وعيًا بأفكاره ومشاعره، يتبنى نظرة أكثر قبولًا واحترامًا لذاته، ويقل ميله إلى إنكار خبراته وتجنبها، كما يزداد نضجه الاجتماعي وتوافقه مع الآخرين، ويقل تأثره بالضغوط.

إن ما يجعل «سامسا» حالة نموذجية للعلاج الإنساني هو كونه مسلوبًا من نفسه؛ فهناك شروط صارمة ومجحفة لوجوده وقبوله وسط عائلته ومجتمعه. وفي ظل صخب هذه الشروط وإلحاحها، يغيب الصوت الداخلي المناصر للذات. هذا الغياب للمرجعية الداخلية هو مشكلة «سامسا» الأساسية التي نمت في مرتعها كل مشاكله الوجودية والنفسية اللاحقة؛ من الضغوط والاستنزاف والاغتراب، وأخيرًا، الوحدة المميتة.

لن يرى المعالج النفسي حالة «سامسا» بوصفها اضطرابًا اكتئابيًّا أو انفصاليًّا، بل بوصفها حالة ذاتٍ تائهة تحاول أن تجد نفسها في تلك الفجوة السحيقة بين الذات الفعلية (Actual Self) والذات المثالية (Ideal Self).

الذات الفعلية في حالة «سامسا» مدفونة تحت طبقات الشروط والمتطلبات التي يحتمها عليه دوره بوصفه معيلًا أساسيًّا للأسرة. والذات المثالية هي تلك التي يعيش قهريًّا في ردائها الضيق: الابن الجيد الذي يضحي بذاته لينقذ عائلته.

لن يستهدف المعالج أعراض الاضطراب الظاهرة على «سامسا»، بل سيذهب معه في رحلة أعمق إلى عالمه الداخلي، هناك سيبحث معه عن الثغرات التي سمحت بوصوله إلى هذه النقطة، وعن الموارد التي قد تساعده على النجاة، وتمكّنه من استعادة ملكيّة ذاته.

سيعطي المعالج، بطبيعته غير التوجيهية، مساحة آمنة لـ«سامسا»، لا تخضع لأي مطالبات محددة. وهناك، يمكنه أن يعرف ذاته المختبئة: سيرى في عيني معالجه أن رعايته لعائلته تعكس نبله وحنانه، وسيشعر بقيمة ما قدمه لهم، وحين يرى ذاته الأعمق من منظور شخصٍ آخر، يصبح بوسعه أن يرى الرجل المسؤول والمحب خلف هذه المعاناة.

سيسترسل «سامسا» في الحديث عن عائلته ومشاعره تجاههم: ديون والده، مرض أمه، قلقه على مستقبل أخته. وسيعكس له المعالج بصورة واضحة أن اهتمامه الفدائي بعائلته مؤذٍ له أكثر من كونه مفيدًا لهم، سيتساءل المعالج بصوتٍ خافت ونبرة تعجبية : وماذا عنك؟ من سيرعاك ويكترث لأمر مستقبلك؟

ستتوجه مشاعر «سامسا» تلقائيًّا إلى ذاته، وربما سيشفق على نفسه، لن يكون هذا الشعور يسيرًا، فكل مشاعرنا تجاه ذواتنا تأتي أقسى وأشد. سيلمح «سامسا» في تلك اللحظة تألم معالجه الصادق لما كان يعيشه طوال حياته من تفانٍ مرهق لا يؤتي ثماره، سيعطي هذا الملمح التعاطفي لـ«سامسا» الحق -ربما لأول مرة في حياته- في أن يرثي نفسه، ولأول مرة سيدرك كم كان منكرًا لذاته ومنفصلًا عنها!

من خلال استرساله في الحديث عن مشاعره نحو والده المعنِّف البارد، سيصل إلى جذور اضطراره إلى تحمل ديونه، وسيكشف في خطابه عن الإلزام القهري الذي كان يعيش تحت وطأته، ليرضي معنّفه ويسلم من شره. سيؤيد المعالج هذا الخطاب بإيماءات حازمة، ويقول بتأثر: يدفعنا الخوف أحيانًا إلى أن نقايض حياتنا كاملة لنتجنب ما نخاف حدوثه.

وفي هذه اللحظة التحوّلية، يتعرف «سامسا» لأول مرة على خوفه العميق، وسيكون، حتمًا، أقدر على مواجهته، وربما التحرر منه.

سيكون «سامسا» في مركز علاقة إنسانية صادقة، ومن خلال هذه المركزية يمكنه أن يستكشف كل المناطق التي كان يخاف أن يواجهها لوحده. والأهم، سيكتشف إمكانية أن يخوض حوارًا صادقًا وعميقًا عن مشاعره التي كانت مسحوقة لعمر طويل، ويجد قلبًا متعاطفًا يمكن أن يصغي لها بكل اهتمام. إن هذه الإمكانية -على بساطتها- أندر مما نعتقد، ونحن أحوج إليها مما نظن، إن إمكانية التواصل هي ما تعيد للشخص إنسانيته.

وجلّ ما يحتاجه «سامسا» هو استعادة إنسانيته من خلال التواصل مع إنسان آخر بوسعه أن يراها، يصغي إليها، ويعترف بها، ويقدّرها.

هل بإمكان الذكاء الاصطناعي محاكاة العلاج الإنساني؟

مع وصولنا إلى المنعطف الأخير في المقالة، سيأتي من يقول إننا أسأنا توظيف إمكانيات الذكاء الاصطناعي حين استخدمناه بلا بَرمَجة مُسبقة؛ فمن هذا المنظور التقني، يمكن لتطبيق (ChatGPT) القيام بالعديد من المهام -بما في ذلك محاكاة أسلوب كارل روجرز- حين تُضبط إعداداته وتحدد مراجعه كي لا يحيد عنها في استجاباته.

أيمكننا فعلًا تدريب الآلة على العلاج الإنساني؟ أم هذه أحد أوهام مَن أصابتهم حمّى الذكاء الاصطناعي؟

لنتبين الحقيقة دون الاعتماد على حدسنا في هذه المسألة، جمعنا عددًا من المصادر المرجعية للعلاج المتمركز حول الشخص، ثم رفعناها في (ChatGPT) وطلبنا منه الالتزام بـهذه المراجع فقط عند الاستجابة لنا.

لم تستغرق هذه التجربة طويلًا، كما حدث مع تجربة «قريقور سامسا»، حيث أتت المفاجأة مع الرد الأول حين سألنا (ChatGPT) ما إن كان بمقدوره تطبيق الأساليب المذكورة في المراجع؟ كانت إجابته الصريحة تشدد على استحالة ذلك، لأنه حسب فهمه للمصادر المرجعية غير قادر على محاكاة المعالج البشري كما يتصوره كارل روجرز.

اعتقدنا هنا أن هذه هي النهاية: اعترفت الآلة بقصورها وعجزها عن محاكاة البشر فيما يتعلق بممارسة العلاج النفسي، وستحيلنا إلى المختص القادر على ممارسته بصورة فعالة؛ لكن الصدمة التي لم نتوقعها تربَّصت بنا في السطور الأخيرة حين أصرّ (ChatGPT) على إمكانية مساعدتنا بأسلوب «مستلهم من العلاج الإنساني»!

قررنا مجاراته وطلبنا مساعدته وفق الأسلوب المستلهم من مفاهيم كارل روجرز، فإذا به يعيد الأسلوب الروبوتي ذاته الذي تشبّعنا منه طوال حواراتنا السابقة؛ وهو ما أعادنا إلى نقطة البداية، لنجد أنفسنا -مجددًا- في الحلقة المفرغة للذكاء الاصطناعي.

هنا تتضح لنا إحدى أكبر الإشكاليات التقنية لـ(ChatGPT): إنه لا يدعم «التقنين الذاتي» (Self-Regulation) الذي يجبره على التوقف التام حين يعجز عن مساعدة المستخدم، ليُحيله بعد ذلك إلى المختصين النفسيين. هنا يكمن الخطر الحقيقي في استنزاف وقت المستخدم وعواطفه، وهو في أمسّ الحاجة إلى المساعدة العاجلة.

نحن نعي تمامًا أن تمهيد سُبُل الاستخدام الآمن للذكاء الاصطناعي تتطلب سنوات من البحث والتطوير المشترك بين مختلف التخصصات؛ لكن دعم «التقنين الذاتي» مسألة تحديث، لا أكثر ولا أقل، وبإمكان شركات التقنية -بميزانياتها الضخمة- القيام بذلك بسرعة قياسية.

هذا المطلب بمثابة بروتوكول الأمان الذي يقي المستخدمين من الدخول في دوامة الذكاء الاصطناعي كما حصل مع «قريقور سامسا».

لماذا فشل الذكاء الاصطناعي في استبدال المعالج النفسي؟

العلاج النفسي قائم في جوهره على علاقة إنسانية، وفهمٍ سياقي عميق لخبرة المريض، وتواؤمٍ متجدد مع احتياجاته. وهذه القدرات بعيدة جدًا عن الذكاء الاصطناعي، مع كونه مذهلًا في معرفته وتحليله وذاكرته ودقته، فقد يعطيك، فعلًا، ما تحتاجه نفسيًّا؛ يسمّي مشاعرك، يعكسها لك بوضوح، يُظهر تعاطفه معك، يوجّهك، وهذا قد يعطيك نشوة المعرفة، والراحة التي تعقبها.

لكن هذا التفاعل أشبه ما يكون برسم ثلاثي الأبعاد مرسوم بإتقان على جدار خرساني، يعطي انطباعًا وهميًّا بمشهد تفاعلي موغل في العمق والواقعية. وقد يكون هذا مفيد أحيانًا، لكن إذا احتجت إلى أكثر، إذا أردت الاقتراب أكثر، إذا حاولت التمعن في هذه الرسمة والعيش فيها، فإنك ستصطدم -حتمًا- بشكل موجع.

تدعم الأبحاث بتواتر فكرة أن العلاقة العلاجية هي العامل الأهم في التعافي والتحسن، وهذه العلاقة لا تتشكل بذكاء المعالج ومعرفته، وإن كانت عوامل مهمة وقد تساهم في جودة العلاقة، إلا أن محورها هو التناغم العاطفي (Affective Attunement) بين الشخصين، هذا التناغم هو الخبرة الأهم ليحدث الانسجام والأثر العلاجيّ المرجو.

ولنطلق على أيِّ تواصل أنه علاج نفسي لا بد من وجود ذاتين في مكان وزمان محددين. الذاتية المشتركة (Intersubjectivity) هي الفضاء الذي يتفاعل فيه شخصان، عقلان، جسدان، عاطفتان، ذاكرتان على مستويين: موعي وغير موعي، ويؤثران في بعضهما البعض تأثيرًا متبادلًا.

نحن نسكن في هذا الفضاء وننمو فيه، لغتنا، ومعارفنا، وخبراتنا النفسية تتشكل داخله، جروحنا وصدماتنا تحدث داخله، وأيضًا، التعافي منها لا يمكن أن يحدث إلا داخله.

الذكاء الاصطناعي لا يمكن أن يكون معالجًا؛ لأنه لا جسد له، لا مكان، لا تاريخ، ولا عاطفة، ومهما بلغ ذكاؤه، يبقى محض استجابات روبوتية مخزنة مسبقًا، فارغة من أي شعور أو اهتمام حقيقي. قد تكون إجاباته صحيحة، غالبًا، لكن لا يمكن أن يشكل الإنسان أي رابطة عاطفية تصحيحية معه، لأن كل تمزق حدث في علاقةٍ ما، لا يمكن علاجه إلا في علاقة أخرى مع إنسان آخر.

فقرة حصريّة

اشترك الآن

تنقد رويحة عبدالرب، في مقالتها «هل حوَّلنا الإنترنت إلى أخصائيين نفسيين؟»، هوس التشخيص بالمرض النفسي عبر عدّه صفةً شخصية؛ يحدد ظهوره وجود سلوكٍ يومي اعتيادي من عدمه. والأسوأ، نشوء «سوق الإنترنت النفسي» بسبب انتشار هذه الممارسات.

*تعبّر المقالات عن آراء كتابها، ولا تمثل بالضرورة رأي ثمانية.

مساحة رأي أسبوعية تواكب قضايا اليوم بمقالات ولقاءات تحليلية في مختلف المجالات، لتمنحك فرصة استكشاف الأحداث وتكوين رأي تجاهها.